Redes para Treino de Modelos de IA: Guia Completo de Infraestruturas, Estratégias e Futuro

Nos últimos anos, a Inteligência Artificial (IA) deixou de ser um conceito futurista para se tornar o motor que impulsiona inovação em setores como saúde, finanças, entretenimento e manufatura. No coração desse avanço está a necessidade de redes robustas para treino de modelos de IA. Seja você um pesquisador, engenheiro de dados ou empreendedor, entender como escolher, dimensionar e otimizar essas redes pode ser decisivo para alcançar resultados competitivos.

1. Por que a escolha da rede de treinamento é tão crítica?

Treinar modelos de deep learning exige bilhões de operações matemáticas por segundo. A velocidade de convergência, a precisão final e o custo de operação dependem diretamente de:

- Capacidade computacional: GPUs, TPUs ou ASICs especializados.

- Escalabilidade da rede: capacidade de distribuir o treinamento entre múltiplas máquinas.

- Latência e largura de banda: comunicação entre nós, essencial para técnicas como data parallelism e model parallelism.

- Eficiência energética: custos operacionais e impacto ambiental.

Ignorar qualquer desses fatores pode levar a treinamentos que demoram semanas ou meses, ou ainda a resultados sub‑ótimos que não justificam o investimento.

2. Tipos de infraestruturas para treinamento de IA

2.1. Computação local (on‑premise)

Empresas que precisam de total controle sobre dados sensíveis (ex.: informações de saúde) costumam investir em servidores próprios. As vantagens incluem:

- Segurança física e lógica total.

- Personalização de hardware (ex.: clusters de GPUs Nvidia A100 ou TPUs da Google).

- Possibilidade de integração profunda com sistemas legados.

Entretanto, o custo inicial é elevado, e a manutenção requer equipe especializada.

2.2. Cloud Computing

Plataformas como AWS SageMaker, Google AI Platform e Microsoft Azure ML oferecem recursos elásticos sob demanda. Principais benefícios:

- Escalabilidade instantânea – aumente ou diminua o número de nós conforme a necessidade.

- Modelo pay‑as‑you‑go, reduzindo CAPEX.

- Serviços gerenciados de armazenamento de dados, pipelines de ML e monitoramento.

Para projetos que exigem experimentação rápida ou picos de carga, a nuvem costuma ser a escolha mais racional.

2.3. Edge Computing

Quando a latência deve ser mínima (ex.: veículos autônomos, IoT industrial), o treinamento pode acontecer próximo ao ponto de coleta de dados. Soluções como NVIDIA Jetson ou Google Coral permitem fine‑tuning de modelos diretamente no dispositivo.

3. Estratégias de paralelismo para acelerar o treino

Mesmo com hardware potente, o tamanho dos datasets modernos (terabytes) e a complexidade dos modelos (bilhões de parâmetros) exigem técnicas avançadas de paralelismo.

3.1. Data Parallelism

Cada nó recebe uma cópia completa do modelo e processa um subconjunto dos dados. Após cada passo de otimização, os gradientes são agregados via all‑reduce. Bibliotecas como PyTorch Distributed e TensorFlow MirroredStrategy facilitam a implementação.

3.2. Model Parallelism

Quando o modelo não cabe na memória de uma única GPU, ele é dividido entre vários dispositivos. Essa abordagem é comum em grandes transformers (ex.: GPT‑4). Frameworks como Megatron‑LM e Mesh TensorFlow oferecem suporte nativo.

3.3. Pipeline Parallelism

Combina as duas técnicas acima: diferentes estágios do modelo são alocados a diferentes GPUs, formando um pipeline que processa micro‑batches em paralelo. Isso reduz a latência de comunicação e melhora a utilização do hardware.

4. Redes de alta performance: o que considerar?

A seguir, os principais critérios para escolher a rede ideal para o seu projeto de IA.

- Largura de banda: conexões de 100 Gbps ou superiores (InfiniBand HDR) são recomendadas para clusters com mais de 8 GPUs.

- Topologia: fat‑tree ou dragonfly minimizam congestionamentos.

- Latência: essencial para all‑reduce frequente; latências abaixo de 1 µs são ideais.

- Escalabilidade: a rede deve suportar a adição de nós sem re‑arquitetura.

- Custos operacionais: energia, refrigeração e manutenção.

\n

Para quem ainda não possui infraestrutura própria, serviços de cloud oferecem high‑speed interconnects como Google Cloud Interconnect ou AWS P4d instances, que trazem performance comparável a data‑centers dedicados.

5. Casos de uso reais e exemplos práticos

5.1. Treino de grandes LLMs (Large Language Models)

Modelos como GPT‑3 foram treinados em clusters com milhares de GPUs Nvidia V100, conectados via InfiniBand. O custo total estimado ultrapassa US$ 4 milhões. A estratégia combinou model parallelism (divisão de camadas) e pipeline parallelism para reduzir o tempo de comunicação.

5.2. Visão computacional em tempo real

Empresas de vigilância utilizam edge clusters com Jetson AGX Xavier para fine‑tuning de redes de detecção de objetos. A rede local processa frames a 30 fps, enviando apenas eventos relevantes para a nuvem.

5.3. Simulação de química computacional

Plataformas como AlphaFold requerem GPUs de alta memória (A100 80 GB) e redes de 200 Gbps para troca de gradientes entre nós. O resultado foi a predição de estruturas proteicas com precisão sem precedentes.

6. Tendências emergentes para 2025 e além

O panorama das redes de treino de IA está em constante evolução. Alguns movimentos que merecem atenção:

- Treinamento federado (Federated Learning): permite que dispositivos descentralizados treinem um modelo coletivo sem compartilhar dados brutos, reduzindo riscos de privacidade.

- Hardware especializado: ASICs como Graphcore IPU ou Cerebras Wafer‑Scale Engine prometem maior eficiência energética.

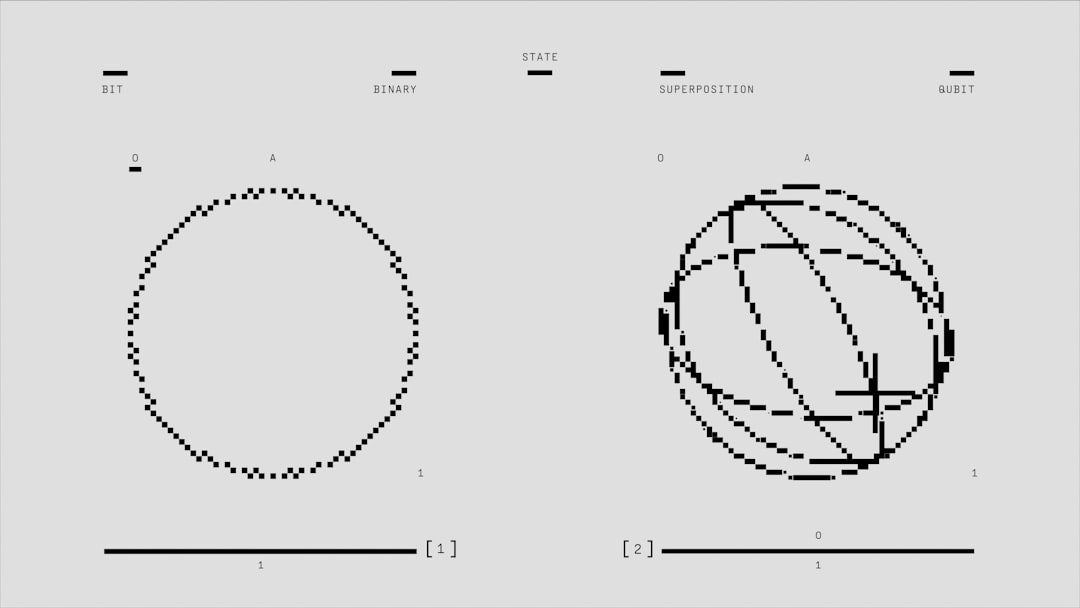

- Integração com computação quântica. Embora ainda em fase experimental, a combinação de qubits para otimização de hiperparâmetros pode acelerar processos críticos. Veja mais em Computação Quântica e Blockchain.

- Redes de baixa latência via 5G/6G: permitem que dispositivos de borda enviem atualizações de modelo quase em tempo real.

Essas inovações exigirão que profissionais de IA continuem se atualizando sobre novas arquiteturas de rede e estratégias de treinamento.

7. Boas práticas para reduzir custos e melhorar eficiência

- Perfilamento de recursos: use ferramentas como NVIDIA Nsight ou TensorBoard para identificar gargalos.

- Mixed precision training: treine com float16 ou bfloat16 quando suportado, reduzindo consumo de memória e acelerando cálculos.

- Checkpointing inteligente: salve apenas pesos críticos e utilize gradient checkpointing para economizar memória.

- Uso de spot instances: em clouds, instâncias spot podem reduzir custos em até 80 %.

- Automação de pipelines: orquestre o fluxo de dados com Apache Airflow ou Kubeflow para evitar retrabalho.

8. Conclusão

Escolher a rede correta para o treino de modelos de IA não é apenas uma decisão de hardware, mas uma estratégia de negócio. Avaliar requisitos de latência, escalabilidade, segurança e custo é essencial para garantir que seu projeto entregue valor real.

Ao combinar infraestruturas on‑premise, nuvem ou edge, aplicar técnicas avançadas de paralelismo e manter-se atento às tendências – como O Futuro da Web3 e o Trilema da Blockchain – você estará preparado para enfrentar os desafios de treinamento de IA em 2025 e além.

Se você deseja aprofundar ainda mais o tema, recomendamos a leitura de artigos especializados e a participação em comunidades como arXiv e OpenAI Research, que publicam os últimos avanços em arquitetura de redes e otimização de treinamento.